1

تخيلو معايا عندكم بيانات ويستوعبها الجهاز العادي في رام او ميموري 32 او 64 قيقا...

هاذي البيانات ما تصنف انها بيانات ضخمة ولكن لو حبينا نخزن بيانات اكبر من هاذي السعة فين ممكن نخزنها؟

تخيلو معايا عندكم بيانات ويستوعبها الجهاز العادي في رام او ميموري 32 او 64 قيقا...

هاذي البيانات ما تصنف انها بيانات ضخمة ولكن لو حبينا نخزن بيانات اكبر من هاذي السعة فين ممكن نخزنها؟

2

اما نخزنها في:-

-DB

-Hard Drive

-Distributed Systems

وهنا يجي دور Spark ,,,

وفي حال لقيت نفسك في يوم انك مضطر تستخدم Spark فانت في نقطة لا يمكن فيها انك تستخدم راماتك او جهازك لتخزين البيانات.

اما نخزنها في:-

-DB

-Hard Drive

-Distributed Systems

وهنا يجي دور Spark ,,,

وفي حال لقيت نفسك في يوم انك مضطر تستخدم Spark فانت في نقطة لا يمكن فيها انك تستخدم راماتك او جهازك لتخزين البيانات.

5

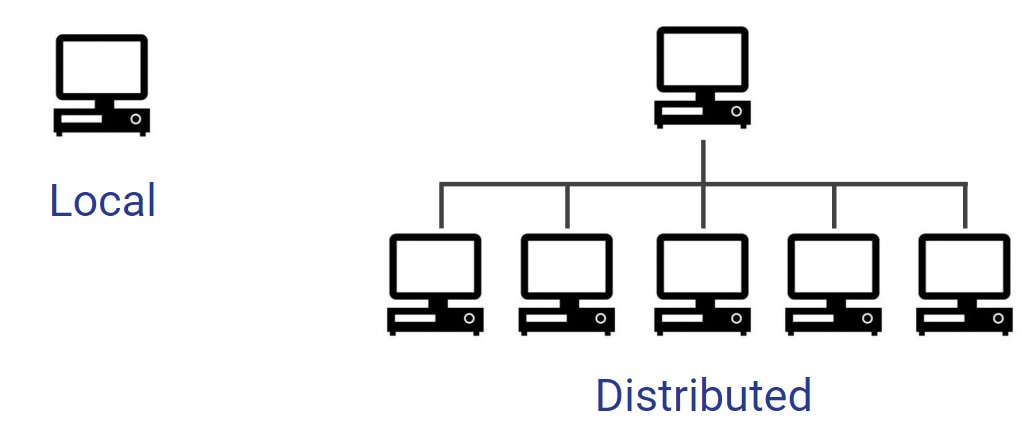

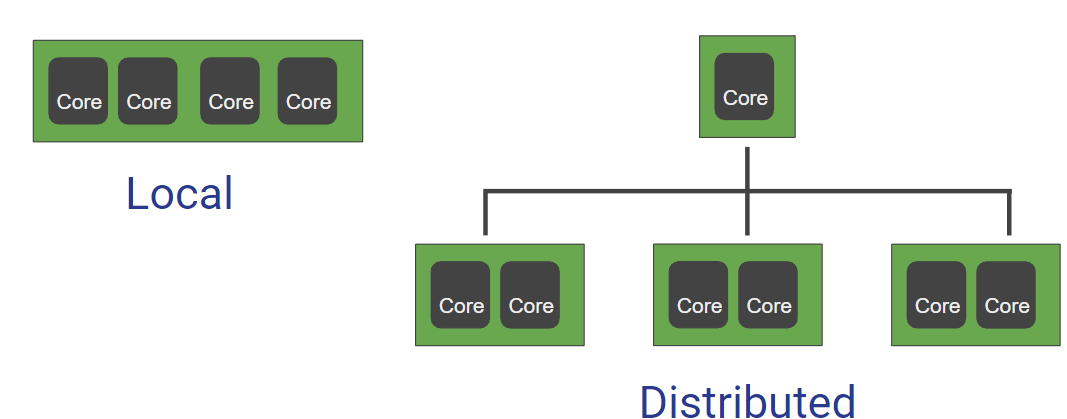

الفرق بينهم انه في الـ Local راح تكون محصور بعدد معين من الانوية والقدرات والموارد بينما في الـ Distributed راح توزع القدرات على اجهزة متعددة ولكن اقل كفاءة وبهذا العدد الاكبر راح تنتهي بقدرات اقوى حاسوبيا من جهاز او نظام واحد.

الفرق بينهم انه في الـ Local راح تكون محصور بعدد معين من الانوية والقدرات والموارد بينما في الـ Distributed راح توزع القدرات على اجهزة متعددة ولكن اقل كفاءة وبهذا العدد الاكبر راح تنتهي بقدرات اقوى حاسوبيا من جهاز او نظام واحد.

6

ويميزها ايضا انو ممكن يزيد عدد المشينز حسب الاحتياج بدون ما يحتاج زيادة سعة المعالج،، وهي نفس الفكرة الي يسويها سبارك.

-

ولو اتكلمنا عن الـ Fault tolerance في الـ Distributed راح يكون افضل بمراحل،، في حال تعرض مشين واحد لتلف كل النتتورك لازالت قادرة على العمل بدون مشاكل.

ويميزها ايضا انو ممكن يزيد عدد المشينز حسب الاحتياج بدون ما يحتاج زيادة سعة المعالج،، وهي نفس الفكرة الي يسويها سبارك.

-

ولو اتكلمنا عن الـ Fault tolerance في الـ Distributed راح يكون افضل بمراحل،، في حال تعرض مشين واحد لتلف كل النتتورك لازالت قادرة على العمل بدون مشاكل.

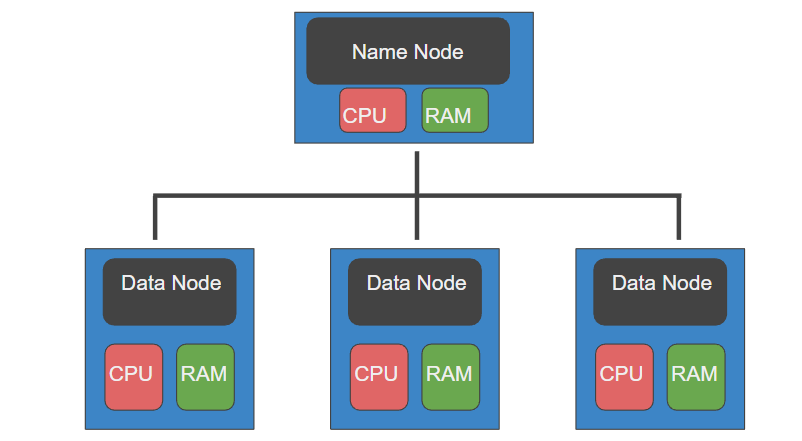

8

بحيث لو كان فيه فقد لنسخة معينة راح يكون فيه لها اكثر بديل ومتوزعة في اكثر من مكان"زي النسخ الاحتياطي".

-

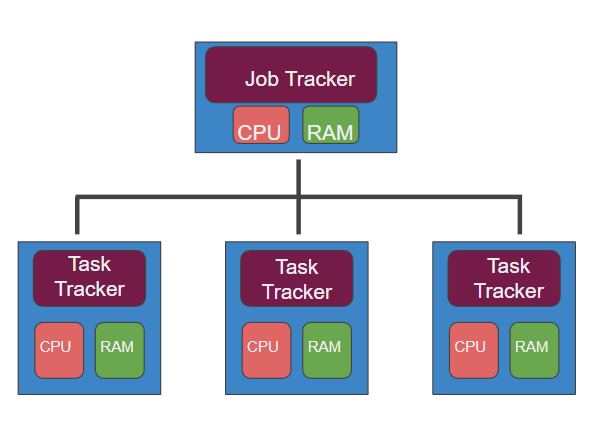

ويستخدم HFDS الـMap Reduce وهو الي يسمح باجراء العمليات الحسابية على هاذي البيانات الموزعة.

-

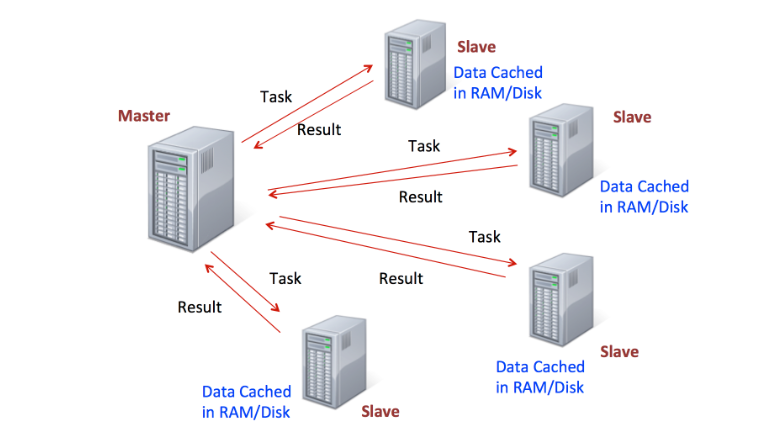

وعشان توضح فكرة HFDS راح يكون فيه Master node لها قدراتها المعالجية الخاصة.

بحيث لو كان فيه فقد لنسخة معينة راح يكون فيه لها اكثر بديل ومتوزعة في اكثر من مكان"زي النسخ الاحتياطي".

-

ويستخدم HFDS الـMap Reduce وهو الي يسمح باجراء العمليات الحسابية على هاذي البيانات الموزعة.

-

وعشان توضح فكرة HFDS راح يكون فيه Master node لها قدراتها المعالجية الخاصة.

12

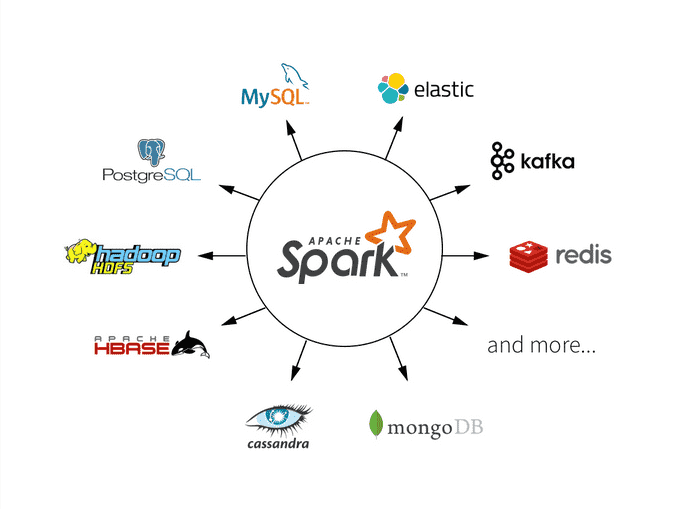

ممكن تتخيل سبارك على انو بديل لـMap Reduce قادر على انو يتعامل مع البيانات بشتى صيغ تخزينها زي :-

-Cassandra

-AWS S3

-HDFS

وغيرها الكثير.

ممكن تتخيل سبارك على انو بديل لـMap Reduce قادر على انو يتعامل مع البيانات بشتى صيغ تخزينها زي :-

-Cassandra

-AWS S3

-HDFS

وغيرها الكثير.

13

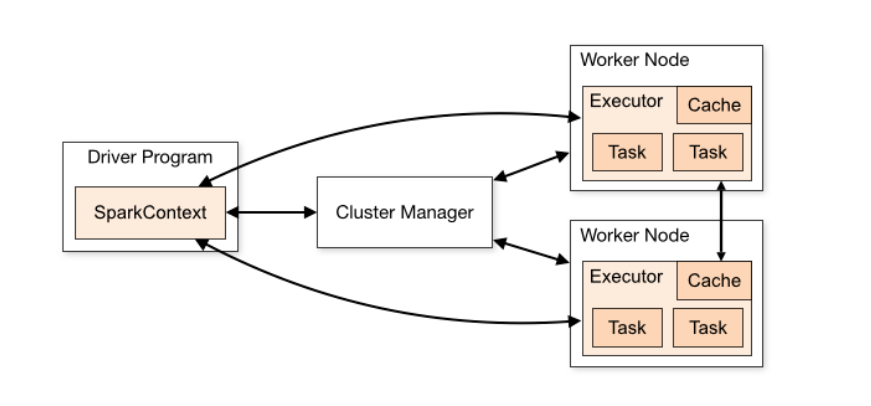

الفكرة الرئيسية لعمل سبارك هي

Resilient Distributed Dataset RDD

والـRDD يحتوى على 4 خصائص:-

-Distributed Collection of Data

-Fault-tolerant

-Parallel operation - partitioned

-Ability to use many data sources

الفكرة الرئيسية لعمل سبارك هي

Resilient Distributed Dataset RDD

والـRDD يحتوى على 4 خصائص:-

-Distributed Collection of Data

-Fault-tolerant

-Parallel operation - partitioned

-Ability to use many data sources

جاري تحميل الاقتراحات...