مؤخرا سار تطور رهيب في مجال #الذكاء_الاصطناعي باصدار منظمة OpenAI النسخة الثانية من النموذج الخاص فيهم DALL.E 2 (دالي ٢). فكرة النظام تقوم على انشاء صور ابداعية بطريقة مبهرة !! وممكن نستغني في القريب عن بعض الوظائف التي تتطلب ابداع تصويري. 👇سلسلة مراجعة للورقية العلمية

هنا الدكتور مازن تكلم عن الموضوع

وايضا الاستاذ عبدالله

لكن هنا حتكلم عن الموضوع من ناحية الورقة العلمية نفسها. حراجع الورقة العملية الخاصة ب دالي ٢. في البداية هذا رابط المقالة التي كتبتها: akadyma.com·e-2-مراجعة-الورقة-العملية/

اولا ما هيا ما هي فكرة تطبيق DALL.E 2 (دالي-٢)؟ قوة النموذج تكمن في نقطتين: 1- قدرة النظام على انشاء صور بناء على وصف يعطى للشبكة العصبية (text to image).

2- قدرة النظام على انشاء رسومات ابداعية عن طريق فقط إعطاء صور للشبكة العصبية.

2- قدرة النظام على انشاء رسومات ابداعية عن طريق فقط إعطاء صور للشبكة العصبية.

ما هي تفاصيل النموذج المقترح؟

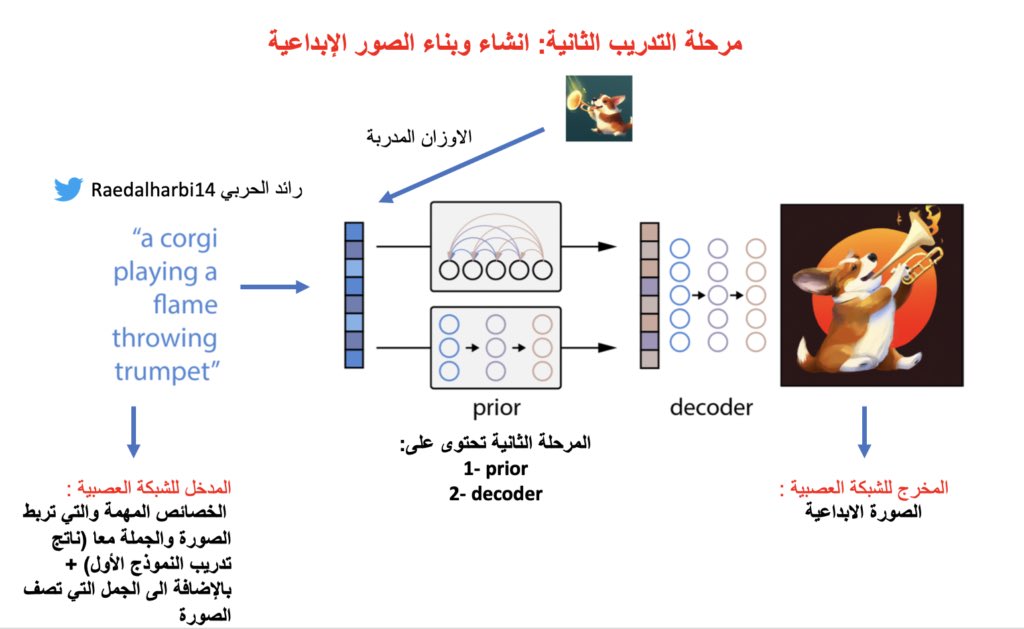

النظام المقترح يتكون من نقتطين:

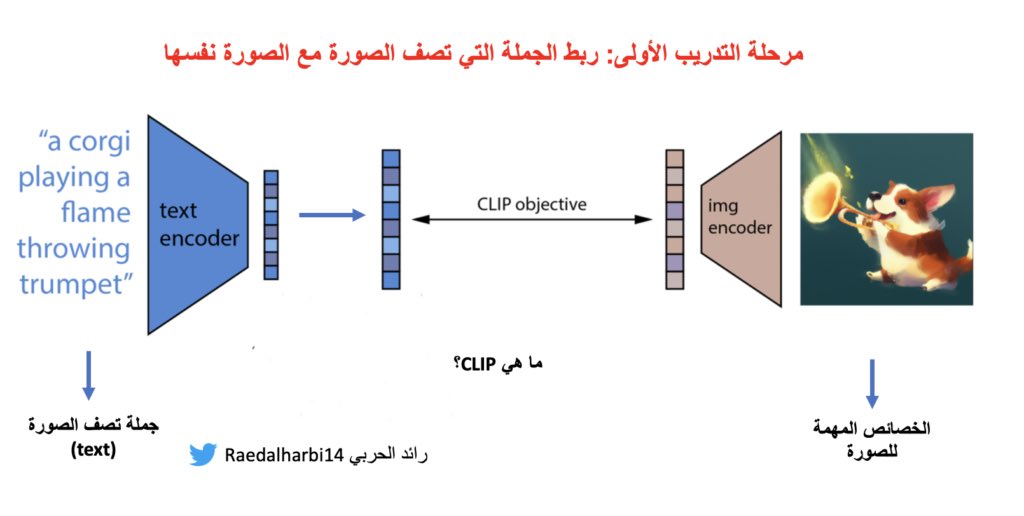

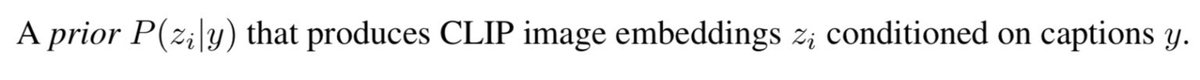

1CLIP (Contrastive Language–Image Pre-training)

2- diffusion model وهو هنا ال decoder

تعال نرى الخطوة الأولى من النموذج المقترح ونشرحها بالتفصيل:

النظام المقترح يتكون من نقتطين:

1CLIP (Contrastive Language–Image Pre-training)

2- diffusion model وهو هنا ال decoder

تعال نرى الخطوة الأولى من النموذج المقترح ونشرحها بالتفصيل:

في صورة الكلب مثلا العيون والخطوط التي تكون صورة الكلب. بعد ذلك، يربط هذه الخصائص بكلمة كلب. كيف يقوم بهذه العملية بالتفصيل؟ التفاصيل بهذه العملية موجودة في ورقة علمية سابقة وهيا CLIP. ولكن الفكرة مثل ما ذكرت لك. طيب ممكن تقول على الاقل ابغى اعرف كيف يعرف انه هذه الجملة ..

للصورة الفلانية؟ هذه بكل اختصار حتكون معطى. يعني تم بناء قاعدة بيانات كبيرة تحتوى ملاين الجمل وفي المقابل لها الصور الخاصة فيها. اذن ما هو مخرج النموذج الأول؟ خصائص الصور مع خصائص الجمل التي لها علاقة بالصورة. يعني كل كل صورة وعندها خصائصها التي تقابلها في الجملة.

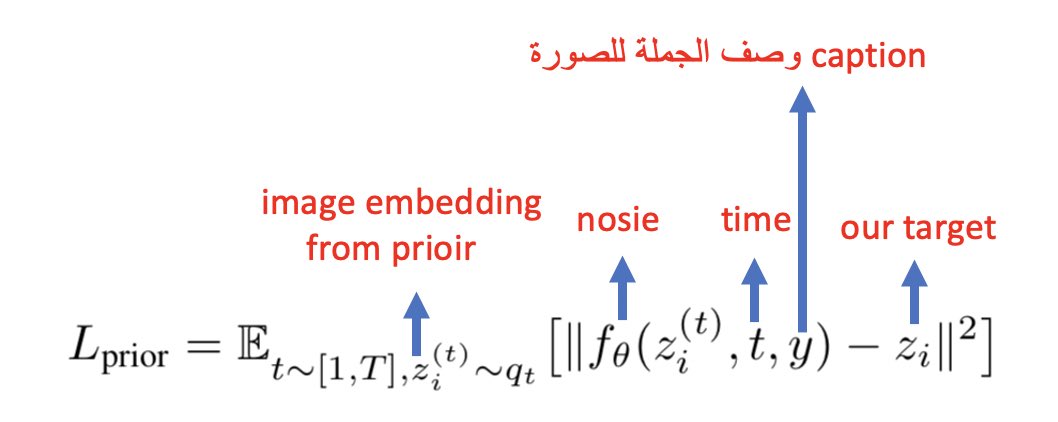

لو تلاحظ كما وصفتها. وهيا انه بشكل مستمر نبدا نضيف nosie وبعدين نعكس العملية حتى نحصل على النتيجة.

decoder: وهنا تم استخدام Diffusion Model لكن بطريقة مختلفة عن الطريقة المعروفة. حعطي مقدمة بسيطة عن فكرة Diffusion Model. بعض النماذج مثل GAN, VAE عندها بعض العيوب وانه ما نستطيع نعممها generalized well بسبب طريقة عملها. وهنا جات فكرة Diffusion Model وهو انه ناخذ عينة

من sampled from a real data distribution واعتبر انه عندي مجموعة صور واخذنا منها صورة وبعد ذلك نضيف لها ارقام عشوائية من Gaussian noise حتى تصبح الصورة غير واضحة ومن ثم نعكس العملية حتى نحصل على الصورة الحقيقة وهذا باستخدام الوقت يعني كل مرة تتم العملية عند ti وهذه

الطريقة اثبتت فعاليتها لكن بما انه مو موضوعي الاساسي عنها فممكن اتكلم عنها بشكل مفصل لاحقا. هنا ال Diffusion Model استخدم بطريقة مختلفة وهيا ان المدخل حيكون خصائص الصور image embeddings والتي كانت من مخرجات ال prior في النقطة الاولى.

هنا اختبرو قوة prior عن طريق انهم اخذو الصورة الاساسية على اليمين وحولوها project الى CLIP latent space. وبعدين استخدمو PCA ليعطيهم اعلى نقاط مهمة ومثل ما نشوف في اخر صورة على اليسار. الصورة حافظت على الاشياء الاساسية من غير ما تقولنا ايش المدينة هذه بالضبط. ماذا يفيدنا هذا؟

هذا يدل على انه الخصائص المهمة للصورة تم تعلمها بالشكل الصحيح وبالتالي نقدر نستخدمها في تطبيقات اخرى من غير تاثير الاشياء الاخرى. طبعا احد استخدامات PCA انه يحول لي الخصائص الكثيرة الى خصائص قليلة وهذا الي طبقوه هنا فنلاحظ انه اهم الخصائص كانت فعلا متعلقة بفحوى الصورة الاساسية.

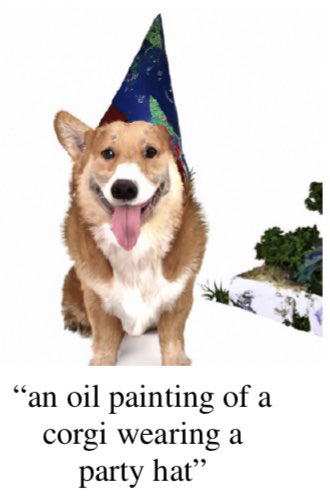

هنا يبغو يشوفون كيفية عمل ال decoder. فاول شي هنا طبقوه انهم اخذو الجملة وفي مثالنا هذا انه” لوحة زيتية لكلب من فصيلة كارجي يرتدي قبعة” بالاضافة الى خصائص الصورة وهيا CLIP image embedding والتي هيا مربوطة بالجملة المعطى مثل ما شفنا كيف قبل. والناتج الصورة التي في الاعلى.

توقعت بعض الاجوبة مثل مدى صعوبة تدريب النموذج ومدى تعقيده لان اتوقع انه من الاهم النقاط والتي تفيدنا في معرفة مدى انشاء تطبيقات مماثلة.

هل تتوقع ان نستغني عن وظيفة المنتج المبدع للصور التسويقية بوجود دالي ٢؟

اخيرا: اتمنى ان نرى معامل بحثية تدعم هالنوع من الابحاث لانها تتطلب اجهزة عالية المواصفات.

جاري تحميل الاقتراحات...