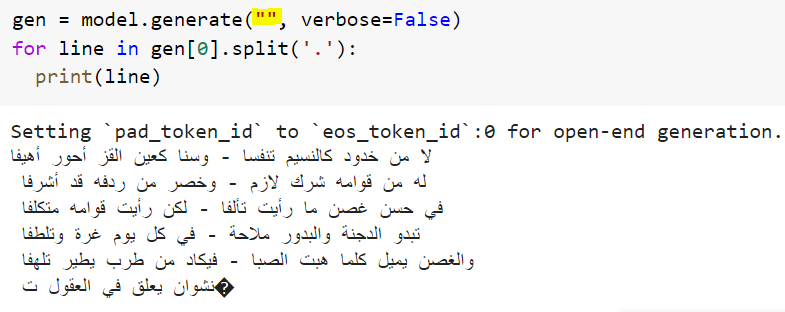

Generating Arabic poetry by fine-tuning the medium GPT2 language model by @aubmindlab (no prompt provided in this example).

A sample code is at the end of this notebook lnkd.in

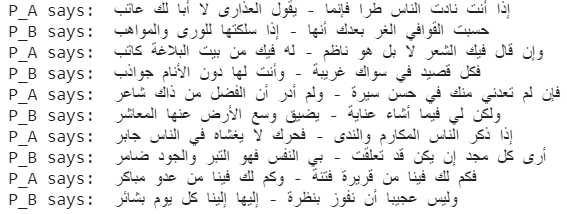

The same notebook now had an additional example (simulation) on poetry retorts (one poet says a line and another replies - as in Jareer and Farazdaq).

This work was possible thanks to all these:

@aubmindlab (Arabic GPT2 models)

@huggingface (Transformers)

@AldiwanNet (source of dataset at kaggle.com)

@t_rajapakse (Simple Transformers)

@GoogleColab (compute)

@ThePSF (Python)

@aubmindlab (Arabic GPT2 models)

@huggingface (Transformers)

@AldiwanNet (source of dataset at kaggle.com)

@t_rajapakse (Simple Transformers)

@GoogleColab (compute)

@ThePSF (Python)

كنت قد سألت أحد العارفين باللغة حول محاولة خوارزمية سابقة فقال

ليس المقصود هنا مجاراة فحول الشعراء وإنما استشراف مستقبل #الذكاء_الاصطناعي ( #التعلم_العميق) والاستعداد لذلك، فالخوارزمية المستخدمة هنا مبنية على الحجم المتوسط للجيل الثاني من النماذج اللغوية، علما أن الجيل الثالث متوفر بالإنجليزية وما زال مقيد الاستخدام.

أما بالنسبة للوزن والقافية والمعنى، فهي من "اجتهاد" الخوارزمية والخبرة المكتسبة من الاطلاع على النصوص الحقيقية، ولم يتم تدريبها على التقيد بذلك، وهو ممكن، ومتروك للباحثين في هذا المجال.

@Rattibha

فضلا

فضلا

جاري تحميل الاقتراحات...